『Black-Box Opinion Manipulation Attacks to Retrieval-Augmented Generation of Large Language Models』を生成AIと学ぶ

まとめ

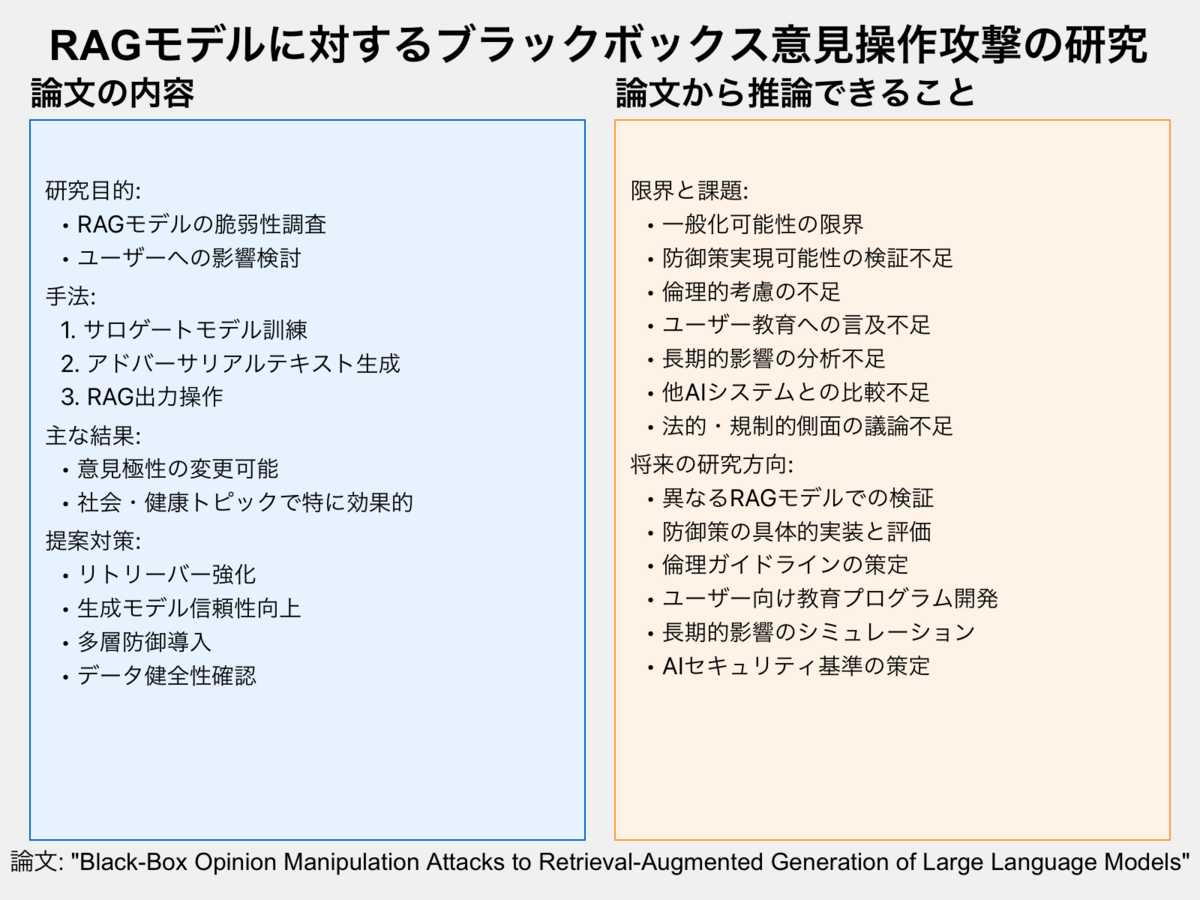

論文に書いてあること

研究目的

手法

- サロゲートモデルを訓練してRAGのリトリーバーを模倣

- アドバーサリアルテキストを生成して検索結果を操作

- 操作された検索結果を用いてRAGモデルの出力を変更

実験設計

主な結果

- 提案された攻撃戦略がRAGの生成コンテンツの意見極性を変更可能

- 社会や健康に関するトピックでの操作が特に効果的

提案された対策

- リトリーバーアルゴリズムの強化

- 生成モデルの信頼性向上

- 多層的な防御機構の導入

- データの健全性確認

論文から言えること(書いてないことや限界)

一般化可能性の限界

防御策の実現可能性

- 提案された対策の具体的な実装方法や効果の検証が不十分

- 誤検出率や計算コストなど、実用化に向けた課題の詳細な分析が必要

倫理的考慮

- 研究結果の公開による潜在的な悪用リスクへの対応策が不明確

- 研究者や開発者の倫理的責任に関する議論が不足

ユーザー側の対策

- AIモデルの出力を批判的に評価するユーザー教育の重要性への言及が不足

- ユーザーが意見操作を検知するための方法や指標の提案が不十分

長期的影響

- この種の攻撃が広く知られるようになった場合のRAGモデルへの信頼性への影響分析が不足

- AIシステムの信頼性評価方法の再考の必要性に関する議論が不足

他のAIシステムとの比較

法的・規制的側面

- このような攻撃に対する法的責任や規制のあり方に関する議論が不足

- AIシステムのセキュリティ基準策定の必要性に関する考察が不足

編集後記

Googleには、サロゲートモデル作る手法は行えないと思うから、RAGは悪意に対する備えがまだなのかなと学びがありました。